Giriş

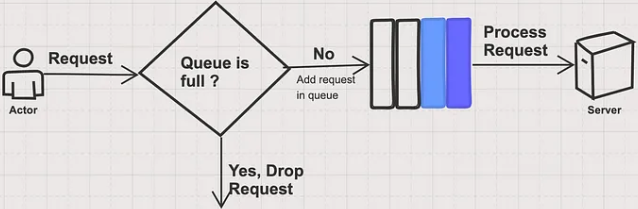

Açıklaması şöyle. Bu yöntem de üst sınır aşılırsa istek es geçilmez ve sonra işlenmek üzere kuyruğa atılır. Bu yöntemi gerçekleştiren bir sınıf burada. Kuyruk ta artık dolarsa, yeni istekler dikkate alınmıyor

The Spike Control Policy is provided for smoothing API traffic. The policy ensures that within any given period of time, no more than the maximum configured requests are processed.

If there is no request quota in the current window, the policy allows requests to be queued for later reprocessing without closing the connection to the client.

Açıklaması şöyle

The leaky bucket limits the constant outflow rate, which is set to a fixed value. For example, if the outflow rate is set to one request per second, it cannot process two requests per second. This ensures the outflow rate is always stable, regardless of the inflow rate.

Şeklen şöyle

Bir başka şekil şöyleGerçekleştirim şöyle

In terms of algorithm implementation, a queue can be prepared to save requests, and a thread pool (ScheduledExecutorService) can be used to periodically obtain requests from the queue and execute them, and multiple concurrent executions can be obtained at one time.This algorithm also has drawbacks after use: it cannot cope with short-term burst traffic.

Bu algoritmanın bir dezavantajı şöyle

This algorithm also has drawbacks after use: it cannot cope with short-term burst traffic.